이번 글은 지난 ReAct 글을 좀 더 자세하게 정리한 글입니다.

https://hexists.tistory.com/252

ReAct

ReAct: Synergizing Reasoning and Acting in Language Models https://ai.googleblog.com/2022/11/react-synergizing-reasoning-and-acting.html ReAct: Synergizing Reasoning and Acting in Language Models Posted by Shunyu Yao, Student Researcher, and Yuan Cao, Rese

hexists.tistory.com

논문을 단락별로 3줄 요약 형식으로 정리해봅니다.

DeepL을 사용해서 번역했습니다.

REACT: SYNERGIZING REASONING AND ACTING IN LANGUAGE MODELS

1 INTRODUCTION

A unique feature of human intelligence is the ability to seamlessly combine task oriented actions with verbal reasoning (or inner speech, Alderson-Day & Fernyhough, 2015), which has been theorized to play an important role in human cognition for enabling self-regulation or strategization (Vygotsky, 1987; Luria, 1965; Fernyhough, 2010) and maintaining a working memory (Baddeley, 1992).

- 인간 지능의 고유한 특징은 작업 중심의 행동과 언어적 추론을 원활하게 결합하는 능력입니다.

- 부엌에서 요리를 하는 경우를 예로 들어보겠습니다.

- "이제 모든 재료가 다 썰어졌으니 냄비를 데워야겠다": 진행 상황을 추적하고

- "소금이 없으니 간장과 후추를 대신 사용해야겠다": 예외 사항을 처리하거나 상황에 따라 계획을 조정하고

- "반죽을 어떻게 준비해야 하지? 인터넷에서 검색해볼게": 외부 정보가 필요한 시점을 깨닫기 위해 언어로 추론할 수 있습니다.

- 요리책을 열어 레시피를 읽고, 냉장고를 열고, 재료를 확인: 또한 추론을 뒷받침하고 질문에 답하기 위해 행동할 수도 있습니다.

- '행동'과 '추론'의 긴밀한 시너지 덕분에 인간은 새로운 작업을 빠르게 학습하고 이전에는 볼 수 없었던 상황이나 정보의 불확실성에 직면한 상황에서도 강력한 의사 결정이나 추론을 수행할 수 있습니다.

Recent results have hinted at the possibility of combining verbal reasoning with interactive decision making in autonomous systems.

- 최근의 연구 결과는 자율 시스템에서 언어적 추론과 대화형 의사 결정을 결합할 수 있는 가능성을 암시합니다.

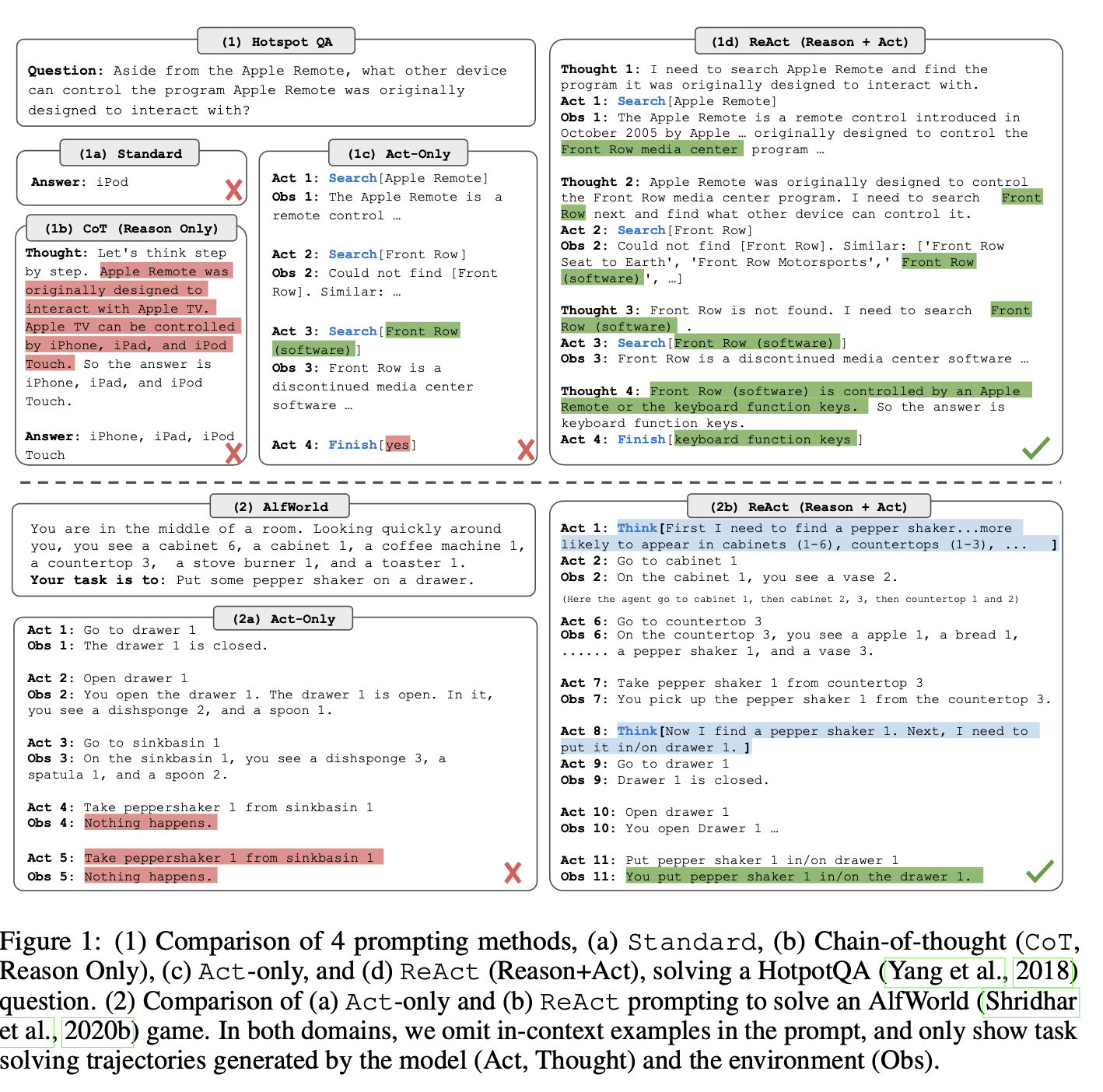

- 'chain-of-thought' 추론은 모델이 자체 내부 표현을 사용하여 생각을 생성하고 외부 세계에 기반을 두지 않는다는 점에서 정적인 블랙박스와 같아서 반응적으로 추론하거나 지식을 업데이트하는 능력이 제한됩니다. 이로 인해 추론 과정에서 사실 착각이나 오류 전파 등의 문제가 발생할 수 있습니다(그림 1 (1b)).

- 반면에 최근의 연구에서는 언어 선험자(language priors)를 통한 행동 예측에 중점을 두고 대화형 환경에서 계획하고 행동하기 위해 사전 학습된 언어 모델을 사용하는 방법을 탐구하고 있습니다. 그러나 높은 수준의 목표에 대해 추상적으로 추론하거나 행동을 지원하기 위한 작업 기억을 유지하기 위해 언어 모델을 사용하지는 않습니다.

- 추론과 행동이 일반적인 과제 해결을 위해 어떻게 시너지 효과를 낼 수 있는지, 그리고 이러한 조합이 추론이나 행동만 단독으로 수행할 때보다 체계적인 이점을 가져올 수 있는지에 대한 연구는 아직 없습니다.

ReAct prompts LLMs to generate both verbal reasoning traces and actions pertaining to a task in an interleaved manner, which allows the model to perform dynamic reasoning to create, maintain, and adjust high-level plans for acting (reason to act), while also interact with the external environments (e.g. Wikipedia) to incorporate additional information into reasoning (act to reason).

- 다양한 언어 추론 및 의사 결정 작업을 해결하기 위해 추론과 행동을 언어 모델과 결합하는 일반적인 패러다임인 ReAct를 제시합니다(그림 1).

- ReAct는 LLM이 과제와 관련된 언어 추론 흔적과 행동을 모두 인터리빙 방식으로 생성하도록 유도하여 모델이 동적 추론을 수행하여 행동에 대한 높은 수준의 계획을 생성, 유지 및 조정하는 동시에(이유에서 행동으로) 외부 환경(예: Wikipedia)과 상호 작용하여 추론에 추가 정보를 통합할 수 있도록 합니다(행동에서 추론으로).

We conduct empirical evaluations of ReAct and state-of-the-art baselines on four diverse benchmarks: question answering (HotPotQA, Yang et al., 2018), fact verification (Fever, Thorne et al., 2018), text-based game (ALFWorld, Shridhar et al., 2020b), and webpage navigation (WebShop, Yao et al., 2022).

- 우리는 질문 답변(HotPotQA, Yang et al., 2018), 사실 확인(Fever, Thorne et al., 2018), 텍스트 기반 게임(ALFWorld, Shridhar et al., 2020b), 웹페이지 탐색(WebShop, Yao et al., 2022)의 네 가지 다양한 벤치마크에서 ReAct와 최첨단 기준선에 대한 경험적 평가를 수행합니다.

- 전반적으로 가장 좋은 접근 방식은 추론 중에 내부 지식과 외부에서 얻은 정보를 모두 사용할 수 있는 ReAct와 CoT를 결합하는 것입니다.

- 추론과 행동의 조합은 일반적인 적용 가능성 및 성능 향상 외에도 인간이 모델 내부 지식과 외부 환경의 정보를 쉽게 구별하고 추론 추적을 검사하여 모델 행동의 결정 근거를 이해할 수 있기 때문에 모든 영역에서 모델 해석 가능성, 신뢰성 및 진단 가능성에도 기여합니다.

To summarize, our key contributions are the following: (1) we introduce ReAct, a novel prompt- based paradigm to synergize reasoning and acting in language models for general task solving; (2) we perform extensive experiments across diverse benchmarks to showcase the advantage of ReAct in a few-shot learning setup over prior approaches that perform either reasoning or action generation in isolation; (3) we present systematic ablations and analysis to understand the importance of acting in reasoning tasks, and reasoning in interactive tasks; (4) we analyze the limitations of ReAct under the prompting setup (i.e. limited support of reasoning and acting behaviors), and perform initial finetuning experiments showing the potential of ReAct to improve with additional training data.

- 일반적인 과제 해결을 위한 언어 모델에서 추론과 행동을 시너지 효과를 내는 새로운 프롬프트 기반 패러다임인 ReAct를 소개합니다.

- 다양한 벤치마크에서 광범위한 실험을 수행하여 추론 또는 행동 생성을 개별적으로 수행하는 이전 접근 방식에 비해 몇 샷 학습 설정에서 ReAct의 장점을 보여줍니다.

- 추론 작업에서 행동의 중요성과 대화형 작업에서 추론을 이해하기 위한 체계적인 추론 및 분석을 제시합니다.

- 프롬프트 설정에서 ReAct의 한계(즉. 즉, 추론 및 행동에 대한 제한된 지원)을 분석하고, 추가 학습 데이터를 통해 개선할 수 있는 ReAct의 잠재력을 보여주는 초기 미세 조정 실험을 수행합니다.

2 REACT: SYNERGIZING REASONING + ACTING

Consider a general setup of an agent interacting with an environment for task solving.

- 에이전트가 작업 해결을 위해 환경과 상호작용하는 일반적인 설정을 생각해 봅시다.

- 시간 t에서 환경으로부터 관측값 ot를 수신하고 어떤 정책 π(at|ct)에 따라 작업을 수행합니다.

- 여기서 ct는 agent에 대한 컨텍스트입니다.

- ct → at 매핑이 매우 암시적이고 광범위한 계산이 필요한 경우 정책을 학습하는 것은 어렵습니다.

- 예를 들어,

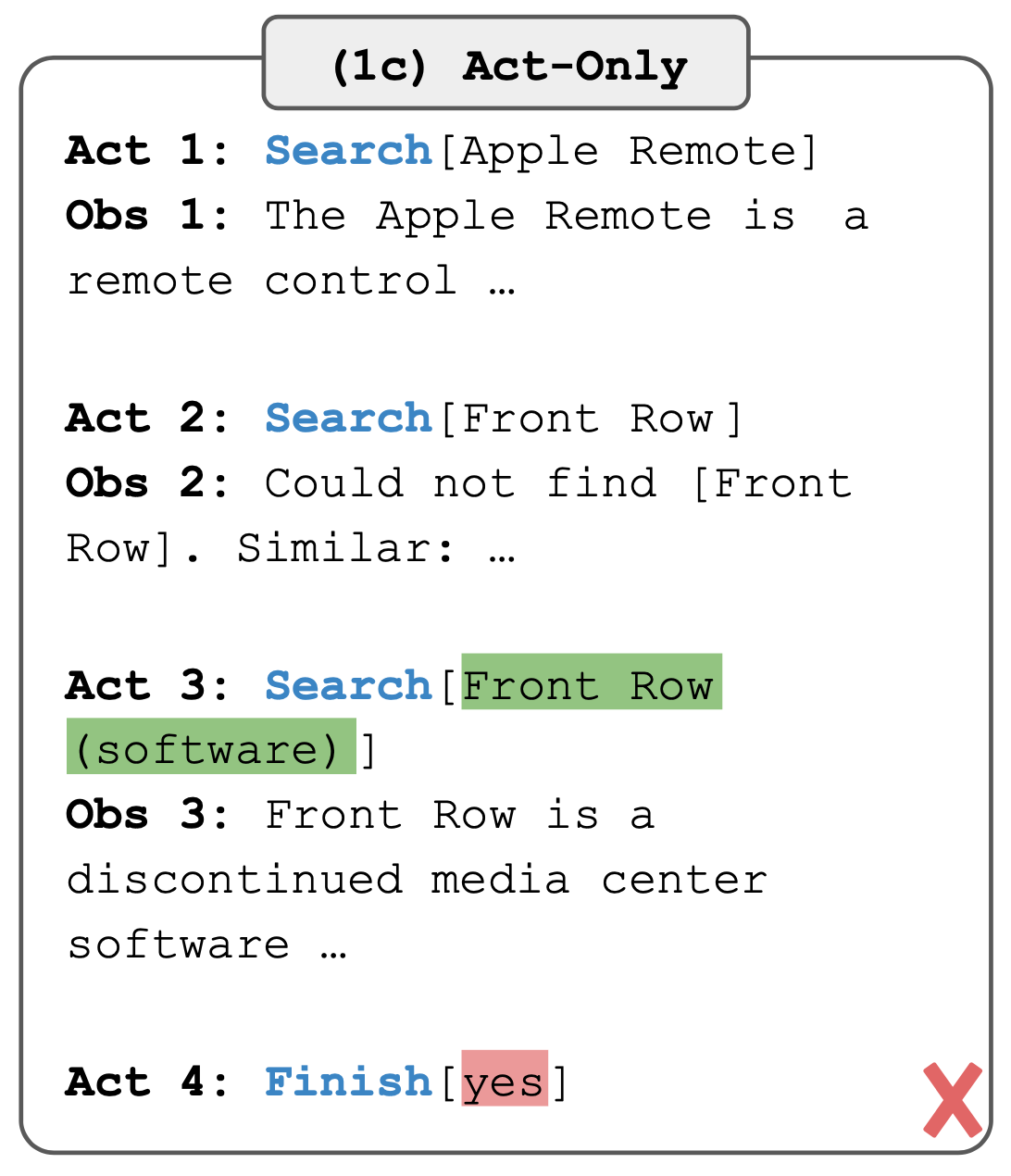

- 그림 1(1c)에서는 복잡한 추론이 필요해서 올바른 최종 작업(Act 4)을 생성하지 못합니다.

- 그림 1(2a)에서는 싱크대 1에 고추쉐이커 1이 포함되어 있지 않다는 문맥을 이해하지 못하여 hallucination을 계속 생성합니다.

The idea of ReAct is simple: we augment the agent’s action space to Aˆ = A ∪ L, where L is the space of language.

- 에이전트의 행동 공간을 Aˆ = A ∪ L로 확장하는 것인데, 여기서 L은 언어의 공간입니다.

- 언어 공간에서 생각 또는 추론 흔적이라고 하는 행동 aˆt ∈ L은 외부 환경에 영향을 미치지 않으므로 관찰 피드백이 발생하지 않습니다.

- 대신, 생각 aˆt는 현재 컨텍스트 ct를 추론하여 유용한 정보를 구성하고, 미래의 추론이나 행동을 지원하기 위해 컨텍스트 ct+1 = (ct, aˆt)를 업데이트하는 것을 목표로 합니다.

- 유용한 생각에는 다양한 유형이 있습니다.

- 작업 목표를 분해하고 실행 계획을 세우기(2b, Act 1, 1d, Thought 1)

- 작업 해결과 관련된 상식적 지식을 주입하기(2b, Act 1)

- 관찰에서 중요한 부분을 추출하기(1d, Thought 2, 4)

- 진행 상황 추적 및 실행 계획 전환(2b, Act 8), 예외 처리 및 실행 계획 조정(1d, Thought 3)

However, as the language space L is unlimited, learning in this augmented action space is difficult and requires strong language priors. In this paper, we mainly focus on the setup where a frozen large language model, PaLM-540B (Chowdhery et al., 2022), is prompted with few-shot in-context examples to generate both domain-specific actions and free-form language thoughts for task solving (Figure 1 (1d), (2b)).

- 그러나 언어 공간 L은 무제한이기 때문에 이 증강 동작 공간에서의 학습은 어렵고 강력한 언어 선행이 필요합니다.

- 본 논문에서는 PaLM-540B(Chowdhery et al., 2022)에 few-shot in-context examples를 제시하여 과제 해결을 위한 도메인별 행동과 자유 형식 언어 사고를 모두 생성하는 설정에 중점을 둡니다(그림 1 (1d), (2b)).

- 각 문맥 내 예시는 과제 인스턴스를 해결하기 위한 행동, 생각, 환경 관찰의 인간 궤적입니다(부록 C 참조).

- 추론이 가장 중요한 과제(그림 1(1))의 경우, 생각과 행동을 번갈아 가며 생성하여 과제 해결 궤적이 여러 생각-행동-관찰 단계로 구성되도록 했습니다.

- 반면, 다수의 행동을 수반할 가능성이 있는 의사 결정 과제(그림 1(2))의 경우, 생각은 궤적의 가장 관련성이 높은 위치에만 드문드문 나타나면 되므로 언어 모델이 생각과 행동의 비동기적 발생을 스스로 결정하도록 합니다.

Since decision making and reasoning capabilities are integrated into a large language model, ReAct enjoys several unique features.

- 의사 결정 및 추론 기능이 대규모 언어 모델에 통합되어 있기 때문에 리액트에는 몇 가지 고유한 특징이 있습니다.

- 직관적이고 디자인하기 쉽습니다.

- 일반적이고 유연합니다. QA, 사실 확인, 텍스트 게임, 웹 탐색 등 행동 공간과 추론이 필요한 다양한 작업에 적합합니다.

- 성능과 견고함: ReAct는 1~6개의 컨텍스트 내 예제만을 학습하면서 새로운 작업 인스턴스에 대한 강력한 일반화를 보여주며, 다양한 영역에서 추론 또는 행동만 하는 기준선보다 일관되게 우수한 성능을 보여줍니다.

- 사람이 조정하고 제어할 수 있습니다. ReAct는 해석 가능한 순차적 의사 결정 및 추론 프로세스를 제공하여 인간이 추론과 사실의 정확성을 쉽게 검사할 수 있습니다.

3 KNOWLEDGE-INTENSIVE REASONING TASKS

We begin with knowledge-intensive reasoning tasks like multi-hop question answering and fact verification. As shown in Figure 1(1d), by interacting with a Wikipedia API, ReAct is able to retrieve information to support reasoning, while also use reasoning to target what to retrieve next, demonstrating a synergy of reasoning and acting.

- 멀티홉 질문 답변 및 사실 확인과 같은 지식 집약적인 추론 작업부터 시작합니다.

- 그림 1(1d)에서 볼 수 있듯이, 위키피디아 API와 상호 작용하여 추론을 지원하는 정보를 검색하는 동시에 추론을 사용하여 다음에 검색할 대상을 타겟팅함으로써 ReAct는 추론과 행동의 시너지를 발휘합니다.

3.1 SETUP

Domains

We consider two datasets challenging knowledge retrieval and reasoning.

- 우리는 지식 검색과 추론에 도전하는 두 가지 데이터 세트를 고려합니다.

- 두 개 이상의 Wikipedia 구절에 대한 추론이 필요한 멀티홉 질문 답변 벤치마크인 Hot- PotQA(Yang et al., 2018)

- 주장을 검증할 Wikipedia 구절이 존재하는지 여부에 따라 각 주장에 SUPPORTS, REFUTES 또는 NOT ENOUGH INFO 주석이 달린 사실 검증 벤치마크인 FEVER(Thorne et al., 2018)

- 이 작업에서는 두 작업 모두에 대해 질문 전용 설정으로 운영되며, 모델은 지원 단락에 대한 액세스 없이 질문/주장만 입력으로 받고 추론을 지원하기 위해 내부 지식에 의존하거나 외부 환경과의 상호 작용을 통해 지식을 검색해야 합니다.

Action Space

We design a simple Wikipedia web API with three types of actions to support interactive information retrieval

- 세 가지 유형의 액션으로 간단한 Wikipedia 웹 API를 설계합니다.

- 해당 엔티티 위키 페이지에서 처음 5개의 문장을 반환하는 검색[엔티티], 엔티티가 존재하는 경우 해당 엔티티를 반환하거나, 그렇지 않으면 Wikipedia 검색 엔진에서 상위 5개의 유사한 엔티티를 제안하는 검색[엔티티]

- 문자열이 포함된 페이지의 다음 문장을 반환하는 조회[문자열], 브라우저에서 Ctrl+F 기능을 시뮬레이션

- finish[answer], 현재 작업을 answer로 완료

3.2 METHODS

ReAct Prompting

For HotpotQA and Fever, we randomly select 6 and 3 cases2 from the training set and manually compose ReAct-format trajectories to use as few-shot exemplars in the prompts.

- HotpotQA과 Fever의 경우, 훈련 세트에서 6개와 3개의 사례2를 무작위로 선택하고 프롬프트에서 몇 개의 샷 예시로 사용할 ReAct 형식의 궤적을 수동으로 구성합니다.

- 그림 1(d)와 유사하게 각 궤적은 여러 개의 생각-행동-관찰 단계(즉, 밀도 있는 생각)로 구성되며, 다양한 목적에 따라 자유 형식의 생각이 사용됩니다.

- 구체적으로, 질문을 분해하고("x를 검색하고, y를 찾은 다음 z를 찾아야 합니다.")

- Wikipedia 관찰에서 정보를 추출하고("x는 1844년에 시작되었습니다.", "단락은 x를 말하지 않습니다.")

- 자세한 내용은 부록C를 참고

Baselines

We systematically ablate ReAct trajectories to build prompts for multiple baselines.

- 여러 기준선(그림 1(1a-1c)와 같은 형식)에 대한 프롬프트를 구축하기 위해 체계적으로 ReAct 궤적을 없앱니다.

- 표준 프롬프트(Standard)는 ReAct 궤적에서 모든 생각, 행동, 관찰을 제거

- 행동과 관찰을 제거하고 추론 전용 기준선 역할을 하는 Chain-of-thought prompting(CoT)(Wei et al., 2022)

- 행동 전용 프롬프트(Act)는 ReAct 궤적에서 생각을 제거

Combining Internal and External Knowledge

As will be detail in Section 3.3, we observe that the problem solving process demonstrated by ReAct is more factual and grounded, whereas CoT is more accurate in formulating reasoning structure but can easily suffer from hallucinated facts or thoughts.

- 우리는 ReAct가 보여주는 문제 해결 과정이 보다 사실적이고 근거가 있는 반면, CoT는 추론 구조를 공식화하는 데 더 정확하지만 환각적인 사실이나 생각으로 인해 쉽게 어려움을 겪을 수 있음을 관찰했습니다.

- ReAct와 CoT-SC를 통합하고 모델이 다음과 같은 휴리스틱에 따라 다른 방법으로 전환할 시점을 결정하도록 제안합니다.

- ReAct → CoT-SC: ReAct가 주어진 단계 내에서 답을 반환하지 못하면 CoT-SC로 물러납니다.

- CoT-SC → ReAct: n개의 CoT-SC 샘플 중 다수의 답변이 n/2회 미만인 경우(즉, 내부 지식이 해당 작업을 확실하게 지원하지 못할 수 있음), ReAct로 백오프합니다.

Finetuning

Due to the challenge of manually annotating reasoning traces and actions at scale, we consider a bootstraping approach similar to Zelikman et al. (2022), using 3,000 trajectories with correct answers generated by ReAct (also for other baselines) to finetune smaller language models (PaLM-8/62B) to decode trajectories (all thoughts, actions, observations) conditioned on input questions/claims.

- 추론 흔적과 행동을 대규모로 수동으로 주석을 다는 것이 어렵기 때문에, 저희는 Zelikman 외(2022)와 유사한 부트스트래핑 접근법을 고려하고 있습니다.

- ReAct에서 생성된 정답이 있는 3,000개의 궤적(다른 기준선에도 해당)을 사용하여 입력 질문/주장에 따라 궤적(모든 생각, 행동, 관찰)을 디코딩하는 더 작은 언어 모델(PaLM-8/62B)을 미세 조정하고 있습니다.

3.3 RESULTS AND OBSERVATIONS

ReAct outperforms Act consistently

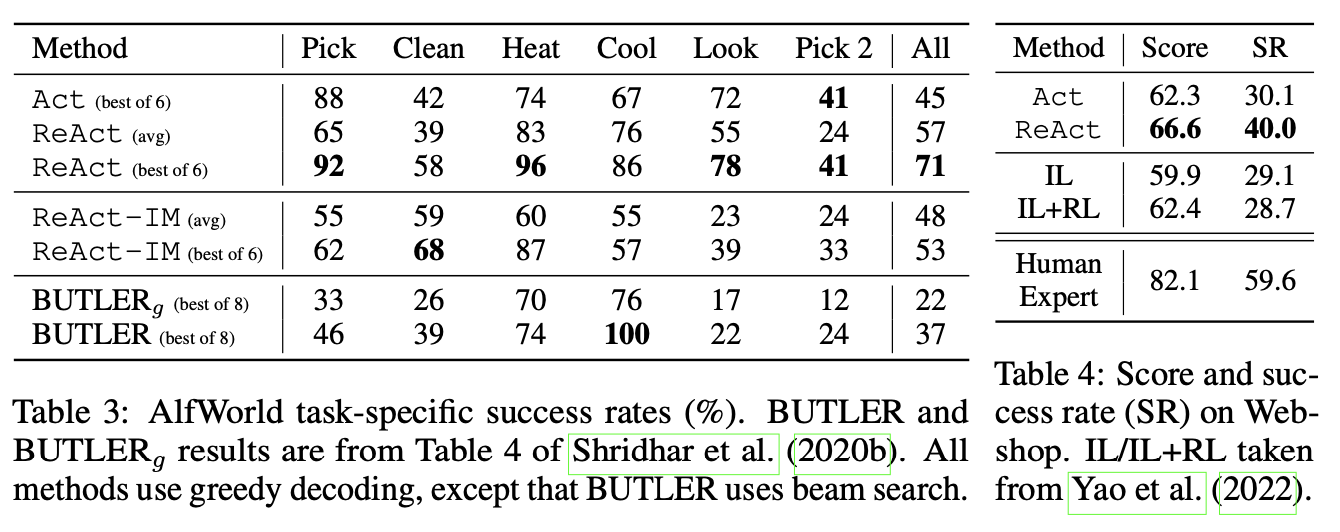

- 표 1은 다양한 프롬프트 방식과 함께 PaLM- 540B를 기본 모델로 사용한 HotpotQA 및 Fever 결과를 보여줍니다.

- 그림 1(1c-d)에서 볼 수 있듯이 두 작업 모두에서 ReAct가 Act보다 우수하며, 특히 최종 답변을 합성하는 데 있어 추론이 행동을 유도하는 데 유용하다는 것을 알 수 있습니다.

- 미세 조정 결과에서도 추론 추적이 더 많은 정보에 기반한 행동을 유도하는 이점이 있음을 확인할 수 있습니다.

ReAct vs. CoT

- 반면, ReAct는 Fever(60.9 대 56.3)에서는 CoT를 능가하고, HotpotQA(27.4 대 29.4)에서는 CoT에 약간 뒤처집니다.

- HotpotQA에서 ReAct와 CoT의 행동 차이를 더 잘 이해하기 위해, 우리는 ReAct와 CoT에서 각각 정답과 오답(EM이 판단)이 있는 궤적 50개(따라서 총 200개)를 무작위로 샘플링하고 표 2에서 성공 및 실패 모드에 수동으로 레이블을 지정했습니다.

key observations

- Hallucination은 CoT의 심각한 문제로, 성공 모드에서 ReAct보다 훨씬 높은 오탐률(14% 대 6%)을 보이며 주요 실패 모드(56%)를 차지합니다. 반면, ReAct 문제 해결 궤적은 외부 지식 기반에 대한 접근 덕분에 보다 근거가 있고 사실에 기반하며 신뢰할 수 있습니다.

- 추론, 행동, 관찰 단계가 교차하는 것은 ReAct의 근거성과 신뢰성을 향상시키지만, 이러한 구조적 제약은 추론 단계를 공식화하는 데 있어 유연성을 감소시켜 CoT보다 더 많은 추론 오류율을 초래합니다.

- 우리는 모델이 이전의 생각과 행동을 반복적으로 생성하는 ReAct 특유의 빈번한 오류 패턴이 있음을 주목하며, 모델이 적절한 다음 조치를 취하고 루프에서 벗어나는 것을 추론하지 못하므로 이를 "추론 오류"의 일부로 분류합니다.

- ReAct의 경우 검색을 통해 유익한 지식을 성공적으로 검색하는 것이 중요합니다.

- 오류 사례의 23%를 차지하는 비정보성 검색은 모델의 추론을 방해하고 생각을 복구하고 재구성하는 데 어려움을 줍니다. 이는 사실성과 유연성 사이에서 예상되는 절충점일 수 있으며, 두 가지 방법을 결합하는 전략을 제안하게 된 동기가 됩니다.

ReAct + CoT-SC perform best for prompting LLMs

- 표 1에 표시된 바와 같이, HotpotQA와 Fever에서 가장 좋은 프롬프트 방법은 각각 ReAct → CoT-SC 및 CoT-SC → ReAct입니다.

- 또한 그림 2는 사용된 CoT-SC 샘플 수에 따른 다양한 방법의 성능을 보여줍니다. 두 가지 ReAct + CoT-SC 방법은 각각 하나의 작업에서 유리하지만, 샘플 수에 따라 CoT-SC보다 훨씬 더 일관되게 성능이 뛰어나며, 3~5개의 샘플만 사용해도 21개의 샘플로 CoT-SC 성능에 도달할 수 있습니다.

- 이러한 결과는 추론 과제에서 모델 내부 지식과 외부 지식을 적절히 결합하는 것이 얼마나 중요한지 보여줍니다.

ReAct performs best for fine-tuning

- 그림 3은 HotpotQA에서 네 가지 방법(표준, CoT, Act, ReAct)의 프롬프트/세부 조정에 따른 스케일링 효과를 보여줍니다.

- PaLM-8/62B를 사용하면 맥락에 맞는 예제에서 추론과 행동을 모두 학습하기 어렵기 때문에 ReAct 프롬프트의 성능이 네 가지 방법 중 가장 떨어집니다.

- 그러나 3,000개의 예제로만 미세 조정하면 ReAct가 네 가지 방법 중 가장 우수한 방법이 되며, PaLM-8B로 미세 조정된 ReAct는 모든 PaLM-62B 프롬프트 방법보다 성능이 뛰어나고, PaLM-62B로 미세 조정된 ReAct는 모든 540B 프롬프트 방법보다 성능이 뛰어납니다.

- 전자는 본질적으로 모델에게 (잠재적으로 환각된) 지식 사실을 암기하도록 가르치고, 후자는 지식 추론에 더 일반화할 수 있는 기술인 위키피디아의 정보에 접근하기 위해 (추론하고) 행동하는 방법을 모델에게 가르치기 때문에, 표준 또는 CoT를 미세 조정하는 것은 PaLM-8/62B 모두에서 ReAct 또는 Act를 미세 조정하는 것보다 훨씬 더 열등합니다.

- 모든 프롬프트 방식은 아직 도메인별 최신 접근 방식과는 상당한 거리가 있기 때문에(표 1), 사람이 직접 작성한 데이터를 더 많이 사용하여 미세 조정하는 것이 ReAct의 성능을 발휘하는 더 좋은 방법일 수 있습니다.

4 DECISION MAKING TASKS

We also test ReAct on two language-based interactive decision-making tasks, ALFWorld and WebShop, both of which feature complex environments that require agents to act over long horizons with sparse rewards, warranting the need for reasoning to act and explore effectively.

또한 언어 기반 대화형 의사 결정 과제인 ALFWorld와 WebShop에서 ReAct를 테스트했는데, 두 과제 모두 에이전트가 보상이 적고 긴 시간 동안 행동해야 하는 복잡한 환경으로, 효과적으로 행동하고 탐색하기 위해 추론이 필요함을 알 수 있었습니다.

ALFWorld

- ALFWorld(Shridhar 외, 2020b)(그림 1(2))는 구현된 ALFRED 벤치마크(Shridhar 외, 2020a)와 일치하도록 설계된 합성 텍스트 기반 게임입니다.

- 여기에는 에이전트가 텍스트 동작(예: 커피 테이블 1로 이동, 종이 2 가져가기, 책상 램프 1 사용)을 통해 시뮬레이션된 가정을 탐색하고 상호 작용하여 높은 수준의 목표(예: 책상 램프 아래 종이 검사)를 달성해야 하는 6가지 유형의 작업이 포함되어 있습니다.

- 작업 인스턴스에는 50개 이상의 장소가 포함될 수 있으며, 해결하려면 50단계 이상의 전문 정책이 필요하므로 에이전트는 하위 목표를 계획하고 추적할 뿐만 아니라 체계적으로 탐색해야 합니다(예: 모든 책상에 데스크 램프가 있는지 하나씩 확인).

- 특히 ALFWorld에 내장된 과제 중 하나는 일반적인 가정용품(예: 책상 스탠드는 책상, 선반 또는 서랍장 위에 있을 가능성이 높음)의 위치를 파악해야 하는 것으로, 이러한 환경은 LLM이 사전 학습된 상식 지식을 활용하기에 적합한 환경입니다.

- ReAct를 유도하기 위해 각 작업 유형에 대해 훈련 세트에서 세 가지 궤적에 무작위로 주석을 달았는데, 각 궤적에는 (1) 목표를 분해하고, (2) 하위 목표 완료를 추적하고, (3) 다음 하위 목표를 결정하고, (4) 상식을 통해 사물을 어디서 찾고 무엇을 할 것인지 추론하는 내용이 포함되어 있습니다.

- Shridhar 등(2020b)에 따라 과제별 설정에서 134개의 보이지 않는 평가 게임에서 평가합니다.

WebShop

- ReAct가 실제 적용을 위해 잡음이 많은 실제 언어 환경과도 상호작용할 수 있을까요?

- 우리는 최근 제안된 온라인 쇼핑 웹사이트 환경으로 118만 개의 실제 제품과 12,000개의 인간 지침이 있는 WebShop(Yao et al., 2022)을 조사합니다.

- ALFWorld와 달리 웹샵에는 매우 다양한 정형 및 비정형 텍스트(예: 아마존에서 크롤링한 제품 제목, 설명, 옵션)가 포함되어 있으며, 에이전트가 사용자 지시(예: "서랍이 달린 협탁을 찾고 있습니다. 니켈 마감으로 되어 있어야 하며 가격은 140달러 미만이어야 합니다.") 웹 상호작용(예: "스탠드 서랍" 검색, "색상: 모던 니켈 화이트" 또는 "검색으로 돌아가기" 등의 버튼 선택)을 통해 제품을 구매해야 합니다.

- 이 과제는 500개의 테스트 지침에 대한 평균 점수(선택한 제품이 모든 에피소드에 걸쳐 평균화된 원하는 속성의 비율)와 성공률(선택한 제품이 모든 요구 사항을 충족하는 에피소드의 비율)로 평가됩니다.

Results

- ReAct는 ALFWorld(표 3)와 Webshop(표 4) 모두에서 Act보다 성능이 뛰어납니다.

- ALFWorld에서 가장 좋은 ReAct 평가판은 평균 71%의 성공률을 달성하여 가장 좋은 Act(45%) 및 BUTLER(37%) 평가판을 크게 앞섰습니다. 심지어 가장 나쁜 ReAct 시험(48%)도 두 방법 중 가장 좋은 시험을 능가합니다.

- 또한, 상대적 성능 향상은 33%에서 90%까지, 평균 62%에 이르는 6개의 대조군 실험에서 Act에 비해 ReAct의 이점이 일관되게 나타났습니다.

- 정성적으로 보면, Act는 전혀 생각하지 않고 목표를 더 작은 하위 목표로 정확하게 분해하지 못하거나 환경의 현재 상태를 파악하지 못한다는 것을 알 수 있었습니다.

- Webshop에서 one-shot Act 프롬프트는 이미 IL 및 IL+RL 방식과 동등한 성능을 발휘합니다.

- sparse reasoning을 추가하면 ReAct는 이전 최고 성공률에 비해 절대적으로 10% 향상된 훨씬 더 나은 성능을 달성합니다.

- 예를 들어, ReAct는 노이즈 관찰과 행동 사이의 간극을 메우기 위해 추론을 통해 지침과 관련된 제품 및 옵션을 식별할 가능성이 더 높다는 것을 확인했습니다(예: "'거실용 공간 절약형 오토만 벤치'의 경우, 해당 품목에는 '39x18x18인치'와 '파란색' 옵션이 있으며 구매하면 좋을 것 같습니다.").

- 그러나 기존 방식은 프롬프트 기반 방식이 수행하기 어려운 훨씬 더 많은 제품 탐색과 쿼리 재구성을 수행하는 전문가(표 4)의 성능에는 아직 미치지 못합니다.

On the value of internal reasoning vs. external feedback

To our knowledge, ReAct is the first demonstration of combined reasoning and action using an LLM applied to an interactive environment within a closed-loop system.

- 우리가 아는 한, closed-loop system 내의 대화형 환경에 적용된 LLM을 사용하여 추론과 행동을 결합한 데모는 ReAct가 처음입니다.

- 아마도 가장 근접한 선행 연구는 Huang 등(2022b)의 내적 독백(IM)으로, 구현된 에이전트의 행동은 시조인 "내적 독백"에 의해 동기를 부여받습니다. 그러나 IM의 '내적 독백'은 환경 상태에 대한 관찰과 목표가 충족되기 위해 에이전트가 완료해야 하는 작업으로 제한됩니다.

- 반면, 의사 결정을 위한 ReAct의 추론 흔적은 유연하고 드물기 때문에 다양한 작업에 대해 다양한 추론 유형(섹션 2 참조)을 유도할 수 있습니다.

- ReAct와 IM의 차이점을 입증하고 외부 피드백에 대한 단순한 반응보다 내적 추론의 중요성을 강조하기 위해, IM과 같은 밀도 높은 외부 피드백으로 구성된 사고 패턴을 사용하여 제거 실험을 진행했습니다.

- 표 3에서 볼 수 있듯이, ReAct는 6개 과제 중 5개 과제에서 일관된 우위를 보이며 IM 스타일의 프롬프트(ReAct-IM)를 크게 앞섰습니다(전체 성공률 71 대 53).

- 질적으로 보면, ReAct-IM은 높은 수준의 목표 세분화가 부족하여 하위 목표가 언제 완료되었는지 또는 다음 하위 목표가 무엇인지 식별하는 데 종종 실수를 저지르는 것으로 나타났습니다.

- 또한, 많은 ReAct-IM 궤적은 상식적인 추론이 부족하여 ALFWorld 환경 내에서 항목이 어디에 위치할지 결정하는 데 어려움을 겪었습니다.

- ReAct 패러다임에서는 이 두 가지 단점을 모두 해결할 수 있습니다.

5 RELATED WORK

Language model for reasoning

- 추론에 LLM을 사용한 가장 잘 알려진 연구는 아마도 문제 해결을 위한 LLM의 '사고 절차'를 공식화할 수 있는 능력을 보여주는 생각의 사슬(Chain-of-Thought, CoT)(Wei et al., 2022)일 것입니다.

- 이후 복잡한 과제 해결을 위한 최소-최대 프롬프트(Zhou et al., 2022), 제로 샷 CoT(Kojima et al., 2022), 자기 일관성을 가진 추론(Wang et al., 2022a) 등 여러 후속 연구가 수행되었습니다.

- 최근 (Madaan & Yazdanbakhsh, 2022)는 CoT의 공식화 및 구조를 체계적으로 연구했으며 기호, 패턴 및 텍스트의 존재가 CoT의 효과에 중요하다는 것을 관찰했습니다.

- 단순한 프롬프트를 넘어 보다 정교한 추론 아키텍처로 확장된 다른 연구도 있습니다.

- 예를 들어, 선택-추론(선택-추론)은 추론 과정을 '선택'과 '추론'의 두 단계로 나눕니다. STaR(Zelikman et al., 2022)은 모델 자체에서 생성된 올바른 근거를 바탕으로 모델을 미세 조정하여 추론 프로세스를 부트스트랩합니다.

- 충실한 추론(Creswell & Shanahan, 2022)은 다단계 추론을 세 단계로 나누고, 각 단계는 각각 전용 LM에 의해 수행됩니다. 중간 계산 단계에서 LM을 미세 조정하는 스크래치패드(Nye et al., 2021)와 같은 유사한 접근 방식도 다단계 계산 문제에 대한 개선 효과를 보여줍니다.

- 이러한 방법과 달리 ReAct는 고립된 고정 추론 이상의 기능을 수행하며, 모델 작업과 해당 관찰을 일관된 입력 스트림으로 통합하여 모델이 더 정확하게 추론하고 추론 이상의 작업(예: 대화형 의사 결정)을 처리할 수 있도록 합니다.

Language model for decision making

- 인공신경망의 강력한 기능 덕분에 언어 생성 이상의 작업을 수행할 수 있게 되었으며, 특히 대화형 환경에서 의사 결정을 위한 정책 모델로 인공신경망을 활용하는 것이 점점 더 대중화되고 있습니다.

- WebGPT(Nakano et al., 2021)는 LM을 사용하여 웹 브라우저와 상호 작용하고, 웹 페이지를 탐색하고, ELI5(Fan et al., 2019)에서 복잡한 질문에 대한 답을 추론합니다. ReAct와 비교하여 WebGPT는 사고 및 추론 절차를 명시적으로 모델링하지 않고, 대신 강화 학습을 위해 값비싼 사람의 피드백에 의존합니다. 대화 모델링에서는 BlenderBot(Shuster et al., 2022b), Sparrow(Glaese et al., 2022)와 같은 챗봇과 SimpleTOD(Hosseini-Asl et al., 2020)와 같은 작업 지향 대화 시스템도 LM이 API 호출에 대한 결정을 내릴 수 있도록 훈련합니다.

- ReAct와 달리 이 시스템들은 추론 절차를 명시적으로 고려하지 않으며, 정책 학습을 위해 값비싼 데이터 세트와 사람의 피드백 수집에 의존합니다. 반면, ReAct는 의사 결정 과정에서 추론 절차에 대한 언어 설명만 필요하기 때문에 훨씬 더 저렴한 방식으로 정책을 학습합니다.

LLMS have also been increasingly employed in interactive and embodied environments for planning and decision making. Perhaps most relevant to ReAct in this respect are SayCan (Ahn et al., 2022) and Inner Monologue (Huang et al., 2022b), which use LLMs for robotic action planning and decision making. In SayCan, LLMs were prompted to directly predict possible actions a robot can take, which is then reranked by an affordance model grounded on the visual environments for final prediction. Inner Monologue made further improvements by adding the eponymous “inner monologue", which is implemented as injected feedback from the environment. To our knowledge, Inner Monologue is the first work that demonstrates such a closed-loop system, which ReAct builds on. However, we argue that Inner Monologue does not truly comprise of inner thoughts — this is elaborated in Section 4. We also note that leveraging language as semantically-rich inputs in the process of interactive decision making has been shown to be successful under other settings (Abramson et al., 2020; Karamcheti et al., 2021; Huang et al., 2022a; Li et al., 2022). It is becoming more evident that with the help of LLMs, language as a fundamental cognitive mechanism will play a critical role in interaction and decision making. What is more, progress in LLMs has also inspired the development of versatile and generalist agents like Reed et al. (2022).

- 계획 및 의사 결정을 위한 대화형 및 구체화 환경에서도 LLMs가 점점 더 많이 사용되고 있습니다.

- 이러한 측면에서 ReAct와 가장 관련성이 높은 사례로는 로봇의 행동 계획 및 의사 결정에 LLM을 사용하는 SayCan(Ahn et al., 2022과 Inner Monologue(Huang et al., 2022b)를 들 수 있습니다.

- SayCan에서는 로봇이 취할 수 있는 가능한 행동을 직접 예측하도록 LLM을 유도한 다음, 시각 환경에 기반한 어포던스 모델을 통해 최종 예측 순위를 재조정했습니다.

- 이너 모놀로그는 환경으로부터 주입된 피드백으로 구현되는 시조인 '이너 모놀로그'를 추가하여 더욱 개선되었습니다. 우리가 알기로는 이너 모놀로그가 이러한 폐쇄 루프 시스템을 보여준 최초의 작품이며, ReAct는 이를 기반으로 합니다.

- 그러나 우리는 이너 모놀로그가 실제로 내면의 생각으로 구성되어 있지 않다고 주장하며, 이에 대해서는 섹션 4에서 자세히 설명합니다. 또한 대화형 의사결정 과정에서 의미적으로 풍부한 입력으로 언어를 활용하는 것은 다른 환경에서도 성공적인 것으로 나타났습니다(Abramson et al., 2020; Karamcheti et al., 2021; Huang et al., 2022a; Li et al., 2022).

- LLM의 도움으로 언어가 근본적인 인지 메커니즘으로서 상호 작용과 의사 결정에 중요한 역할을 할 것이라는 것이 더욱 분명해지고 있습니다.

- 또한 LLM의 발전은 Reed 등(2022)과 같은 다재다능하고 제너럴리스트 에이전트의 개발에도 영감을 주었습니다.

6 CONCLUSION

We have proposed ReAct – a simple yet effective method for synergizing reasoning and acting in large language models. Through a diverse set of experiments on multi-hop question-answering, fact checking, and interactive decision-making tasks, we show that ReAct leads to superior performance with interpretable decision traces. Despite the simplicity of our method, complex tasks with large action spaces require more demonstrations to learn well, which unfortunately can easily go beyond the input length limit of in-context learning. We explore the fine-tuning approach on HotpotQA with initial promising results, but learning from more high-quality human annotations will be the desiderata to further improve the performance. Scaling up ReAct with multi-task training and combining it with complementary paradigms like reinforcement learning could result in stronger agents that further unlock the potential of LLMs for more applications.

- 대규모 언어 모델에서 추론과 연산을 시너지 효과를 낼 수 있는 간단하면서도 효과적인 방법인 ReAct를 제안했습니다.

- 멀티홉 질문-답변, 사실 확인, 대화형 의사 결정 작업에 대한 다양한 실험을 통해 ReAct가 해석 가능한 의사 결정 추적을 통해 우수한 성능을 이끌어낸다는 것을 보여주었습니다.

- 간단한 방법에도 불구하고 행동 공간이 큰 복잡한 작업은 제대로 학습하기 위해 더 많은 데모가 필요하며, 안타깝게도 인컨텍스트 학습의 입력 길이 한계를 쉽게 넘어설 수 있습니다.

- 핫팟QA에서 미세 조정 접근 방식을 살펴본 결과 초기에는 유망한 결과를 얻었지만, 성능을 더욱 개선하려면 더 많은 고품질의 사람 주석을 통해 학습해야 합니다.

- 멀티태스크 트레이닝으로 ReAct를 확장하고 강화 학습과 같은 상호 보완적인 패러다임과 결합하면 더 많은 애플리케이션에서 LLM의 잠재력을 더욱 발휘할 수 있는 더 강력한 에이전트가 탄생할 수 있습니다.

'Computer > LLM' 카테고리의 다른 글

| OpenAI Responses API 이해하기 (0) | 2025.08.14 |

|---|---|

| 영화 Her에서 느꼈던 AI Agent의 모습 (0) | 2023.07.14 |

| ReAct (0) | 2023.05.31 |

| MLM vs CLM (0) | 2023.04.20 |

| InstructGPT Evaluation (2) | 2023.04.17 |